اشتباه عجیب هوش مصنوعی فیسبوک

سیستم هوش مصنوعی فیسبوک در اقدامی عجیب، یک ویدیوی مربوط به سیاهپوستان را در دسته ویدیوهای نخستیسانان قرار داده بود که البته این شبکه اجتماعی ساعاتی پیش و پس از این اشتباه فاحش، از کاربران عذرخواهی کرد. سیستم مربوطه در حال حاضر غیرفعال شده تا مشخص شود که چه چیزی باعث بروز این مشکل شده است.

به گزارش نیویورک تایمز، کاربرانی که اخیرا ویدیوی حاوی سیاهپوستان از خبرگزاری «دیلی میل» را مشاهده کرده بودند، با پیامی از سوی فیسبوک مواجه شدند که از آنها خواسته بود در صورت تمایل ویدیوهای مشابهی درباره نخستیسانان را تماشا کنند. این شرکت بابت بروز این اشتباه غیرقابل پذیرش از کاربران عذرخواهی و سیستم پیشنهاد فیسبوک را غیرفعال کرده تا ببیند چگونه میتواند جلوی وقوع مجدد چنین خطاهای فاحشی را بگیرد.

«دنی لِور»، سخنگوی فیسبوک در بیانیهای در این باره گفت: «همانطور که گفته بودیم، علیرغم تمام بهینهسازیهایی که روی هوش مصنوعیمان انجام دادهایم، میدانیم که این فناوری بینقص نیست و هنوز باید آن را اصلاح کنیم. از هر کسی که ممکن است این پیشنهادهای توهینآمیز را دیده باشد، عذرخواهی میکنیم.»

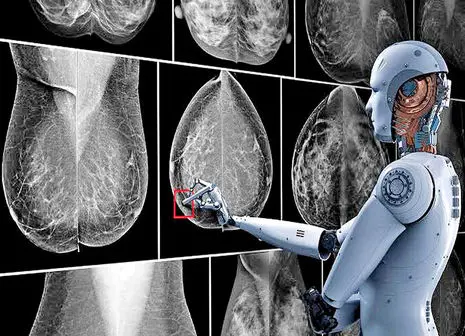

تبعیض نژادی و جنسیتی در هوش مصنوعی منحصر به شبکههای اجتماعی نیست. فناوریهای تشخیص چهره هنوز نقایص بسیار زیادی دارند و در تشخیص افراد رنگینپوست و زنان اشتباهات زیادی میکنند. پارسال یک مورد تشخیص چهره اشتباه به بازداشت نادرست دو مرد سیاهپوست در دیترویت آمریکا منجر شد. در سال ۲۰۱۵ هم گوگل به اشتباه تصویر افراد سیاه پوست را به عنوان گوریل برچسبگذاری کرد.

فیسبوک چند ماه قبل برای حل بخشی از مشکلات سیستم خود مجموعه دادهای را که با کمک متخصصان هوش مصنوعی ایجاد کرده بود، به اشتراک گذاشت. این مجموعه داده شامل بیش از ۴۰ هزار ویدیو با هنرنمایی حدود ۳ هزار بازیگر استخدامی بود که سن و جنسیتهای مختلفی داشتند.

فیسبوک در این پروژه حتی افرادی را استخدام کرد تا نورپردازی صحنه را تنظیم و رنگ پوست افراد را دستهبندی کنند. این شرکت قصد داشت با این کار به سیستمهای هوش مصنوعی خود بیاموزد که نژادهای مختلف در شرایط نوری گوناگون چه شکل و ظاهری دارند. منتها به نظر میرسد که این تلاشها کافی نبودهاند و سیستم فیسبوک هنوز اشکالات اساسی دارد.

ارسال نظر